|

podía haberse predicho hacía algún tiempo y es parte de un problema más grande: el modelo imperante del 'capitalismo vigilante' y las tentaciones del Big Data...

Diversos medios alertamos que Facebook no era "gratuito":

Esto siempre fue algo que se difundió en menor o mayor medida en torno a Facebook, pero realmente no se escuchó, pues "todos están en Facebook" y los beneficios de estar "conectados" eran demasiados, o acaso porque hasta hace poco no se había visto concretamente cómo esta información podía manipular a la opinión pública - algo que vimos desde el Brexit y desde el triunfo de Trump.

Pensamos que porque no

éramos terroristas o criminales no teníamos mucho que perder al

entregar toda nuestra información. Mark Zuckerberg dijo en reiteradas ocasiones que la privacidad estaba sobrevaluada, que lo importante era lo social; incluso afirmó en el 2010 que no creía en la privacidad.

Ahora parece irónico que Facebook y Twitter fueron promovidos como "herramientas para la democracia" o para deponer dictadores en la llamada Primavera Árabe hace algunos años.

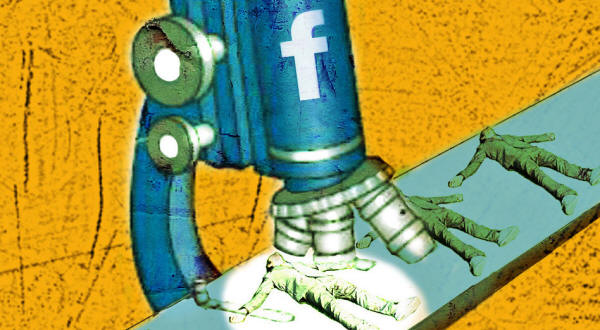

Hace unas semanas, la revelación del caso de los 50 millones de perfiles que minó la empresa Cambridge Analytica para crear anuncios y contenido personalizado para influir en la elección dio un atisbo de lo que puede pasar cuando el Big Data se combina con la propaganda.

Sabemos que con sólo tener acceso a una docena de likes o poco más se puede predecir el sexo, la raza, la orientación política y demás.

Sondeando esta información Cambridge Analytica se jactó de poder entender el tipo de mensajes, el formato, el contenido, el tono y la frecuencia a la cual son susceptibles los usuarios individuales.

A la par montó un equipo de producción de medios y un equipo de diseminación de los productos mediáticos en blogs y perfiles de redes sociales, creados específicamente para promover los contenidos que podrían favorecer esta ingeniería de la percepción.

Asimismo, en base a los perfiles psicológicos y emocionales de los usuarios se crearon anuncios con targets específicos.

Un ex-empleado de esta empresa, Christopher Wylie, dijo que la herramienta que desarrollaron, a diferencia de tomar un megáfono y comunicar un mensaje en una plaza pública es,

Se creó con esto un "arma cultural" y se llevó al extremo la llamada "burbuja de filtro" en la que cada quien recibe una versión personalizada de la realidad en base a sus gustos previos, colocando así a cada usuario en un universo tautológico separado de los demás.

Wylie señaló que la visión de alquimia política del consejero de Trump, Steve Bannon, fue apuntalada bajo este axioma:

Indicios de lo que estamos viendo con el caso de Cambridge Analytica ya se habían mostrado mucho antes.

Por citar un ejemplo notable que se dio a conocer en el 2014, Facebook hizo un experimento con 700 mil jóvenes que fueron manipulados emocionalmente con información en su Newsfeed sin que ellos lo supieran.

Esto siguió pesando, como demuestra un documento filtrado revelado por un diario australiano en el 2017, que muestra que,

Facebook actualmente está enfrentando enormes críticas, citaciones a audiencias en diferentes partes del mundo, sus acciones se desploman en la bolsa y hay un importante (aunque no tan masivo) éxodo de sus usuarios.

Esto ciertamente es sólo el principio, porque el modelo de Facebook y el modelo de Google y otras empresas es más que vender publicidad.

Es lo que ha sido llamado un "capitalismo de vigilancia" (surveillance capitalism):

En la medida en que la inteligencia artificial o el machine learning crece, la tentación de crear algoritmos para predecir o influir en las conductas es demasiado grande, especialmente cuando estas compañías no son realmente humanas, y obedecen simplemente a la prerrogativa de obtener más ganancias...

Esto, a su vez, genera un conflicto de intereses no menor, pues estas plataformas ganan dinero por cada segundo de atención de sus usuarios.

Pero cautivar la atención de sus usuarios, para que la economía digital siga creciendo, necesariamente supone la enajenación y el desarrollo de conductas patológicas en los usuarios.

La economía digital se moviliza por la atención; así entonces, mientras los usuarios consumen información, su atención es consumida, y por lo tanto, quedan en la des-atención o en la distracción.

Para hacer esto, como documentado aquí, se incorporan sofisticadas técnicas al diseño y la programación con las que se activan los sistemas de dopamina - la promesa de recompensa - de los usuarios de la misma manera que las máquinas tragamonedas.

Se podría argumentar que la dopamina digital es algo así como el 'nuevo azúcar'...

Los resultados inevitables del capitalismo de vigilancia y su minería de datos para crear anuncios y predecir conducta han sido bien diagnosticados por el analista Mark Pesce:

Pesce parece sugerir que el sistema está colapsando. Habrá que ver...

Ciertamente Facebook enfrenta posibles regulaciones y algunos países, como ya lo ha hecho China, podrían empezar a limitar su acceso.

Pero más allá de esto, el reto es cómo imaginamos otro mundo metidos en lo hondo de la pecera.

No sólo un mundo sin Facebook, si fuera el caso, sino un mundo humano en el que no estemos en manos de máquinas y algoritmos que nadie controla o que sólo algunos pocos controlan y hasta cierto punto, puesto que, en su ambición, no tienen realmente idea de hasta qué punto están creando algo así como un nuevo Frankenstein o un nuevo pacto fáustico...

|